Lebenslauf / Ausbildung an der Uni / Seminararbeiten / Modality Integration: Speech and Gesture

Modality Integration: Speech and Gesture

3.2.4. Text Editor

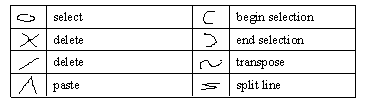

Table 3.2.3 Gesten für Texteditor der Carnegie Mellon University

Von Alexander Waibel und Minh Tue Vo wurde ein multimodales Interface für einen Text-Editor entwickelt. Ziel des Projektes war es, die natürlichen menschlichen Kommunikationsformen Sprache und Gestik in ein Hauptanwendungsgebiet der EDV, die Textverarbeitung, zu integrieren. Durch Markieren von Textteilen durch eine Zeigegeste und eine sprachliche Kommandoausführung (Bsp.: „delete“) könnte man typisch menschliche Verhaltensweisen zum einfachen Editieren von Texten verwenden. Der Ansatz der bei diesem Forschungsprojekt verfolgt wurde, entspricht einem System mit 8 vordefinierten Gesten (siehe Tabelle 3.2.3), die statt oder zur Unterstützung von sprachlichen Kommandos verwendet werden kann. Es handelt sich also nicht um eine vollständige Integration von Sprache und Gestik, sondern um eine getrennte Steuerung durch Sprache und Gestik.

Bsp.: Mit der Selektion eines Textblocks durch eine der oben gezeigten Gesten und der sprachlichen Aufforderung „delete“ kann der selektierte Textblock gelöscht werden. Genauso könnte der selektierte Textblock durch die „Delete“-Geste entfernt werden. Es kann also sowohl mit unimodaler als auch mit mehrmodaler Steuerung gearbeitet werden. Diese Art der Interaktion mit einer Textverarbeitung kommt der natürlichen Kommunikationsform des Menschen entgegen und könnte die elektronische Textverarbeitung nachhaltig unterstützen. Während bei der mehrmodalen Form eine verbundene Auswertung von Sprach- und Gesteneingabe verwendet wird, kann eine unimodale Eingabe getrennte Sprach- oder Gesteninteraktion zu einer Anweisung führen. [9]

Mag. Andreas Bimminger; Raiffeisenstrasse 6; 2326 Maria Lanzendorf; Österreich; Tel.: +43/699/11685959

Sie befinden sich auf https://www.bimminger.at/

im Pfad: Lebenslauf / Ausbildung an der Uni / Seminararbeiten / Modality Integration: Speech and GestureErstellt: 2002-10-07